Mình là một người thích đọc, sau một thời gian đọc những truyện voz buồn cứ phải gọi là … như Ranh Giới của rain8x, hay Ngày Hôm Qua Đã Từng của Nguyễn Mon, ..v.v. và hằng hà sa số truyện chữ khác thì mình quyết định chuyển sang đọc truyện tranh (người đời gọi như vậy chứ toàn thấy ae gọi là đọc manga). Thật tình cờ mình cũng có cái máy kindle để đọc sách (ngựa ngựa mua về để đọc sách chứ toàn đọc truyện tranh là chính), down mấy truyện Conan trên mạng (người ta gọi đó là sách lậu) copy vào Kindle ppw4 thì cảm thấy hơi mờ + bị kéo giãn hình ra trông xấu mù, đầu Conan hình tròn nó kéo thành hình cái bánh mì luôn. Là một người thích giữ những gì bản nguyên nhất của truyện, mình đã quyết định đi tìm nguồn truyện Thần chết Conan - à nhầm, Thám tử lừng danh Conan phải vừa đẹp vừa nét vừa bản nguyên như những gì đáng ra nó phải như thế.

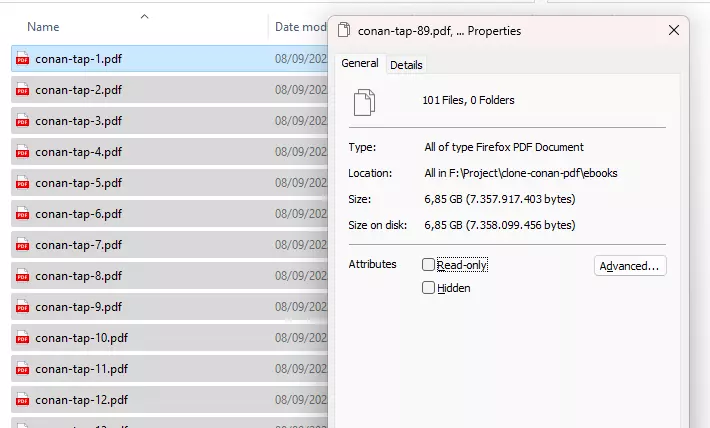

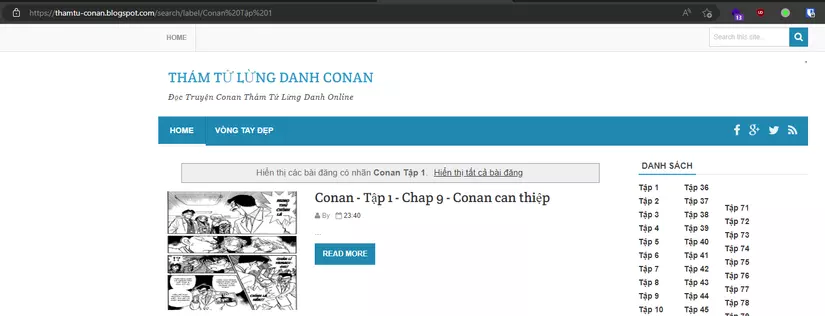

Sau một thời gian tìm kiếm thì mình cũng tìm được trang https://thamtu-conan.blogspot.com/ có đầy đủ những gì mình mong muốn. Đọc truyện trên máy tính thì đau mắt nên mình quyết định viết 1 script crawl truyện từ trang này về và đóng gói lại để đọc trên máy Kindle. Và bên dưới đây là câu chuyện mà mình đi ngồi crawl truyện nè.

Viết script

Đầu tiên là phải ngồi phân tích cấu trúc trang web này đã, trang này được cái là phân tích cũng dễ :rofl:

get_chapter(chapter):

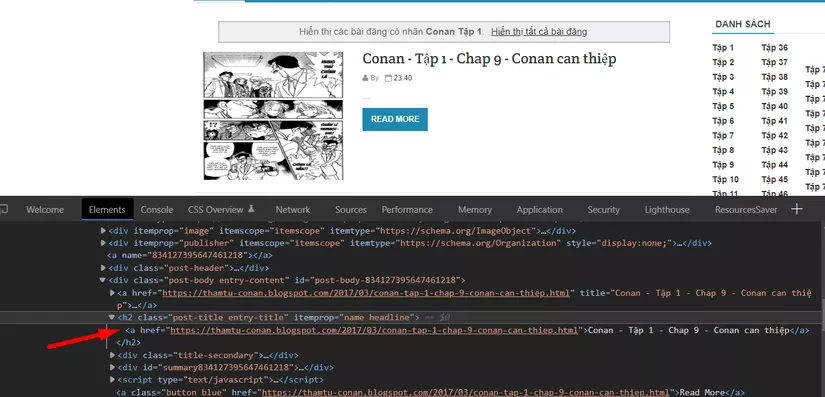

Có các label để chia ra các tập, mỗi tập có nhiều chapter, đầu tiên là mình viết script để get toàn bộ chapter của một tập về đã

| |

Ở đây mình sử dụng bs4 để phân tách code html, lấy code từ đoạn h2 với class post-title vì bên trong nó có cái link chapter :roll_eyes:

Sau đó lấy toàn bộ link trong kết quả trả về là chúng ta có 1 danh sách links chapter cmnr.

get_images(link):

Lấy được toàn bộ link chapter rồi thì download toàn bộ image trong đó về thôi

| |

Tiếp tục sử dụng bs4 để lấy toàn bộ code ở thẻ div, class post-body (vì trong đó có chứa toàn bộ ảnh), sau đó tìm kiếm toàn bộ thẻ img rồi download về theo thứ tự. Ở đây mình có return lại toàn bộ filenames để dùng cho chức năng về sau

save_pdf(fnames, chapter):

| |

Lấy được toàn bộ ảnh rồi thì mình sẽ ghép toàn bộ ảnh của 1 chapter vào 1 file pdf. Mình dùng img2pdf để ghép toàn bộ ảnh thành 1 file pdf cho lẹ. Ở đây mình cần phải có list filenames mình nói bên trên để ép vào code cho nó ngắn gọn, các bạn cũng có thể đọc toàn bộ file trong folder rồi ghép lại cũng được, cũng là một cách.

Mình có thêm code xoá luôn cái ảnh đi để đỡ tốn bộ nhớ, ghép vào lấy mỗi file pdf thôi.

get_chapter_full():

| |

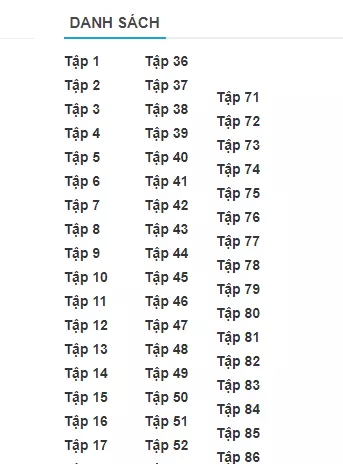

Đoạn này mình viết thêm để lấy toàn bộ links của các tập hiện có trên web (links danh sách bên dưới nè), còn nếu muốn download từng tập thì có thể dùng hàm get_chapter(chapter) để chỉ định cụ thể tập nào.

main:

Mọi thứ xong rồi, giờ đến lúc chạy script thôi :D

- Với những ai muốn download từ tập 1 đến tập cuối luôn thì dùng main như này

| |

- Với những ai muốn download tập cụ thể thì có thể dùng như này

| |

Nhớ import thư viện của python vào để dùng nữa nhé

| |

Chú ý

Code bên trên chỉ dùng để download các chapter, để ghép các chapter thành các tập thì phải viết thêm code nữa để merge vào

| |

Vậy là xong, quá trình đi kéo sách lậu cũng không phải dễ dàng gì mà …